Интерфейсы подключения жестких дисков: SCSI, SAS, Firewire, IDE, SATA. Контроллеры SAS от Adaptec

Введение

Посмотрите на современные материнские платы (или даже на некоторые более старые платформы). Нужен ли для них специальный RAID-контроллер? На большинстве материнских плат есть трехгигабитные порты SATA, также как аудио-разъёмы и сетевые адаптеры. Большинство современных чипсетов, таких как AMD A75

и Intel Z68

, имеют поддержку SATA на 6 Гбит/с. При такой поддержке со стороны чипсета, мощному процессору и наличию портов ввода/вывода, нужны ли вам дополнительные карты для систем хранения и отдельный контроллер?

В большинстве случаев обычные пользователи могут создать массивы RAID 0, 1, 5 и даже 10, используя встроенные порты SATA на материнской плате и специальное ПО, при этом можно получить очень высокую производительность. Но в тех случаях, когда требуется более сложный уровень RAID – 30, 50 или 60 – более высокий уровень управления диском или масштабируемость, то контроллеры на чипсете могут не справиться с ситуацией. В таких случаях нужны решения профессионального класса.

В таких случаях вы больше не ограничены системами хранения SATA. Большое количество специальных карт обеспечивают поддержку SAS (Serial-Attached SCSI) или дисков Fibre Channel (FC), каждый из этих интерфейсов несёт с собой уникальные преимущества.

SAS и FC для профессиональных решений RAID

Каждый из трёх интерфейсов (SATA, SAS и FC) имеет свои плюсы и свои минусы, никакой из них не может быть безоговорочно назван лучшим. Сильные стороны приводов на базе SATA заключаются в высокой ёмкости и низкой цене, в сочетании с высокими скоростями передачи данных. Диски SAS славятся своей надёжностью, масштабируемостью и высокой скоростью ввода/вывода. Системы хранение FC обеспечивают постоянную и очень высокую скорость передачи данных. Некоторые компании до сих пор используют решения Ultra SCSI, хотя они могут работать не более чем с 16 устройствами (один контроллер и 15 дисков). Более того, полоса пропускания в этом случае не превышает 320 Мбайт/с (в случае Ultra-320 SCSI), что не может конкурировать с более современными решениями.

Ultra SCSI – это стандарт для профессиональных корпоративных решений систем хранения. Однако SAS приобретает всё большую популярность, поскольку предлагает не только существенно бoльшую полосу пропускания, но также и большую гибкость при работе со смешанными системами SAS/SATA, что позволяет оптимизировать издержки, производительность, готовность и ёмкость даже в одном единственном JBOD (наборе дисков). Кроме того, многие SAS-диски обладают двумя портами с целью возможности резервирования. Если одна карта контроллера выходит из строя, то переключение дисковода на другой контроллер позволяет избежать отказа всей системы. Таким образом SAS обеспечивает высокую надежность всей системы.

Более того, SAS – это не только протокол "точка-точка" для соединения контроллера и устройства хранения. Он поддерживает до 255 устройств хранения на порт SAS при использовании экспандера. Используя двухуровневую структуру экспандеров SAS, теоретически, можно присоединить к одному каналу SAS 255 x 255 (или чуть больше 65 000) устройств хранения, если конечно контроллер способен поддерживать такое большое число устройств.

Adaptec, Areca, HighPoint и LSI: тесты четырёх контроллеров SAS RAID

В этом сравнительном тесте мы исследуем производительность современных SAS RAID-контроллеров, которые представлены четырьмя продуктами: Adaptec RAID 6805, Areca ARC-1880i, HighPoint RocketRAID 2720SGL и LSI MegaRAID 9265-8i.

Почему SAS, а не FC? С одной стороны, SAS – на сегодня наиболее интересная и уместная архитектура. Она предоставляет такие возможности, как зонирование, которое очень привлекательно для профессиональных пользователей. С другой стороны, роль FC на профессиональном рынке снижается, а некоторые аналитики даже предсказывают её полный уход, основываясь на количестве поставленных жёстких дисков. По мнению экспертов IDC, будущее FC выглядит достаточно мрачным, а вот жёсткие диски SAS могут претендовать на 72% рынка корпоративных жёстких дисков в 2014 году.

Adaptec RAID 6805

Производитель чипов PMC-Sierra вывел на рынок серию "Adaptec by PMC" семейства контроллеров RAID 6 в конце 2010 г. Карты контроллера серии 6 основаны на двухъядерном контроллере ROC (RAID on Chip) SRC 8х6 Гбайт, который поддерживает кэш-память 512 Мбайт и до 6 Гбит/с на SAS-порт. Есть три низкопрофильные модели: Adaptec RAID 6405 (4 внутренних порта), Adaptec RAID 6445 (4 внутренних и 4 внешних порта) и та, что мы тестировали – Adaptec RAID 6805 с восемью внутренними портами, стоимостью около $460.

Все модели поддерживают JBOD и RAID всех уровней – 0, 1, 1E, 5, 5EE, 6, 10, 50 и 60.

Соединённый с системой через интерфейс x8 PCI Express 2.0, Adaptec RAID 6805 поддерживает до 256 устройств через SAS экспандер. В соответствии со спецификациями производителя, стабильная скорость передачи данных в систему может достигать 2 Гбайт/с, а пиковая может достигать 4.8 Гбайт/с на агрегированный SAS-порт и 4 Гбайт/с на интерфейс PCI Express – последняя цифра – максимальное теоретически возможное значение для шины PCI Express 2.0х.

ZMCP без необходимости поддержки

Наш тестовый образец пришел с Adaptec Falsh Module 600, который использует Zero Maintenance Cache Protection (ZMCP) и не использует устаревший Battery Backup Unit (BBU). Модуль ZMCP – это блок с флэш-чипом на 4 Гбайт NAND, который используется для резервного копирования кэш-памяти контроллера в случае отключения энергопитания.

Поскольку копирование из кэш-памяти во флэш-память происходит очень быстро, Adaptec использует конденсаторы для поддержки питания, а не аккумуляторы. Преимущество конденсаторов заключается в том, что они могут работать так же долго, как и сами карты, тогда как резервные аккумуляторы должны заменяться каждые несколько лет. Кроме того, однажды скопированные во флэш-память данные могут храниться там несколько лет. Для сравнения: вы обычно имеете около трёх дней для хранения данных перед тем, как кэшированная информация будет потеряна, что заставляет вас торопиться с восстановлением данных. Как и предполагает само название ZMCP, это решение, способное противостоять отказам по энергопитанию.

Производительность

Adaptec RAID 6805 в режиме RAID 0 проигрывает в наших тестах потокового чтения/записи. Кроме того RAID 0 – это не типичный случай для бизнеса, которому нужна защита данных (хотя он вполне может использоваться для рабочей станции, занимающейся рендерингом видео). Последовательное чтение идёт на скорости 640 Мбайт/с, а последовательная запись – на 680 Мбайт/с. По этим двум параметрам LSI MegaRAID 9265-8i занимает верхнюю позицию в наших тестах. Adaptec RAID 6805 работают лучше в тестах RAID 5, 6 и 10, но не является абсолютным лидером. В конфигурации только с SSD, контроллер Adaptec работает на скорости до 530 Мбайт/с, но его превосходят контроллеры Areca и LSI.

Карта Adaptec автоматически распознаёт то, что она называет конфигурацией HybridRaid, которая состоит из смеси жёстких и SSD-дисков, предлагая RAID на уровнях от 1 до 10 в такой конфигурации. Эта карта превосходит своих конкурентов благодаря специальным алгоритмам чтения/записи. Они автоматически направляют операции чтения на SSD, а операции записи и на жёсткие диски, и на SSD. Таким образом операции чтения будут работать как в системе только из SSD, а запись будет работать не хуже, чем в системе из жёстких дисков.

Однако, результаты наших тестов не отражают теоретической ситуации. За исключением бенчмарков для Web-сервера, где работает скорость передачи данных для гибридной системы, гибридная система SSD и жёстких дисков не может приблизиться к скорости работы системы только из SSD.

Контроллер Adaptec показывает себя гораздо лучше в тесте производительности ввода/вывода для жёстких дисков. Вне зависимости от типа бенчмарков (база данных, файл-сервер, Web-сервер или рабочая станция), контроллер RAID 6805 идёт нога в ногу с Areca ARC-1880i и LSI MegaRAID 9265-8i, и занимает первое или второе места. Только HighPoint RocketRAID 2720SGL лидирует в тесте ввода/вывода. Если заменить жёсткие диски на SSD, то LSI MegaRAID 9265-8i существенно обгоняет три других контроллера.

Установка ПО и настройка RAID

Adaptec и LSI обладают хорошо организованными и простыми в работе средствами для управления RAID. Инструменты управления позволяют администраторам получить удалённый доступ к контроллерам через сеть.

Установка массива

Areca ARC-188oi

Areca также выводит серию ARC-1880 в рыночный сегмент контроллеров 6 Гбит/с SAS RAID. По утверждению производителя, целевые приложения простираются от приложений NAS и серверов систем хранения до высокопроизводительных вычислений, резервирования, систем обеспечения безопасности и облачных вычислений.

Протестированные образцы ARC-1880i с восемью внешними портами SAS и восемью линиями интерфейса PCI Express 2.0 можно приобрести за $580. Низкопрофильная карта, которая является единственной картой в нашем наборе с активным кулером, построена на базе 800 МГц ROC с поддержкой кэша для данных 512 Мбайт DDR2-800. Используя SAS экспандеры, Areca ARC-1880i поддерживает до 128 систем хранения данных. Чтобы сохранить содержание кэша при отказе энергопитания, к системе опционально может быть добавлен аккумуляторный источник питания.

Кроме одиночного режима и JBOD, контроллер поддерживает уровни RAID 0, 1, 1E, 3, 5, 6, 10, 30, 50 и 60.

Производительность

Areca ARC-1880i хорошо справляется с тестами чтения/записи в RAID 0, достигая 960 Мбайт/с для чтения и 900 Мбайт/с для записи. Только LSI MegaRAID 9265-8i оказывается быстрее в этом конкретном тесте. Контроллер Areca не разочаровывает и в других бенчмарках. И в работе с жёсткими дисками, и с SSD, этот контроллер всегда активно конкурирует с победителями тестов. Хотя контроллер Areca стал лидером только в одном бенчмарке (последовательное чтение в RAID 10), он демонстрировал очень высокие результаты, например, скорость чтения в 793 Мбайт/с в то время, как самый быстрый конкурент, LSI MegaRAID 9265-8i, показал только 572 Мбайт/с.

Однако последовательная передача информации – это лишь одна из частей картины. Вторая – производительность ввода/вывода. Areca ARC-1880i и здесь выступает блистательно, на равных соперничая с Adaptec RAID 6805 и LSI MegaRAID 9265-8i. Аналогично своей победе в бенчмарке по скорости передачи данных, контроллер Areca победил и в одном из тестов ввода/вывода – бенчмарке Web-сервер. Контроллер Areca доминирует в бенчмарке Web-сервер на уровнях RAID 0, 5 и 6, а для RAID 10 вперёд вырывается Adaptec 6805, оставляя контроллер Areca на втором месте с небольшим отставанием.

Web GUI и установка параметров

Как и HighPoint RocketRAID 2720SGL, Areca ARC-1880i удобно управляется через Web-интерфейс и просто настраивается.

Установка массива

HighPoint RocketRAID 2720SGL

HighPoint RocketRAID 2720SGL – это SAS RAID-контроллер с восемь внутренними SATA/SAS-портами, каждый из которых поддерживает 6 Гбит/с. По информации производителя, эта низкопрофильная карта ориентирована на системы хранения для малого и среднего бизнеса, и на рабочие станции. Ключевой компонент карты – это RAID-контроллер Marvell 9485. Основные конкурентные преимущества – малые размеры и интерфейс PCIe 2.0 на 8 линий.

Кроме JBOD, карта поддерживает RAID 0, 1, 5, 6, 10 и 50.

Кроме той модели, что была протестирована в наших тестах, в низкопрофильной серии HighPoint 2700 есть ещё 4 модели: RocketRAID 2710, RocketRAID 2711, RocketRAID 2721 и RocketRAID 2722, которые, в основном, отличаются типами портов (внутренний/внешний) и их количеством (от 4 до 8). В наших тестах использовался самый дешёвый из этих RAID-контроллеров RocketRAID 2720SGL ($170). Все кабели к контроллеру приобретаются отдельно.

Производительность

В процессе последовательного чтения/записи в массив RAID 0, состоящий из восьми дисков Fujitsu MBA3147RC, HighPoint RocketRAID 2720SGL демонстрирует отличную скорость чтения 971 Мбайт/с, уступая только LSI MegaRAID 9265-8i. Скорость записи – 697 Мбайт/с – не так высока, но тем не менее превосходит скорость записи Adaptec RAID 6805. RocketRAID 2720SGL также демонстрирует целый спектр самых разных результатов. При работе с массивами RAID 5 и 6 он превосходит другие карты, но с RAID 10 скорость чтения падает до 485 Мбайт/с – самое низкое значение среди четырёх тестируемых образцов. Последовательная скорость записи в RAID 10 ещё хуже – всего 198 Мбайт/с.

Этот контроллер явно не создан для SSD. Скорость чтения здесь достигает 332 Мбайт/с, а скорость записи – 273 Мбайт/с. Даже Adaptec RAID 6805, который также не слишком хорош в работе с SSD, показывает в два раза лучшие результаты. Поэтому HighPoint не является конкурентом для двух карт, которые работают с SSD действительно хорошо: Areca ARC-1880i и LSI MegaRAID 9265-8i – они работают как минимум в три раза быстрее.

Всё, что мы смогли сказать хорошего о работе HighPoint в режиме ввода/вывода, мы сказали. Тем не менее RocketRAID 2720SGL занимает последнее место в наших тестах по всем четырём бенчмаркам Iometer. Контроллер HighPoint вполне конкурентоспособен другим картам при работе с бенчмарком для Web-сервера, но существенно проигрывает конкурентам по трём другим бенчмаркам. Это становится очевидным в тестах с SSD, где RocketRAID 2720SGL явно демонстрирует, что он не оптимизирован для работы с SSD. Он явно не использует все преимущества SSD по сравнению с жёсткими дисками. Например, RocketRAID 2720SGL показывает 17378 IOPs в бенчмарке баз данных, а LSI MegaRAID 9265-8i превосходит его по этому параметру в четыре раза, выдавая 75 037 IOPs.

Web GUI и установки для массива

Web-интерфейс RocketRAID 2720SGL удобен и прост в работе. Все параметры RAID устанавливаются легко.

Установка массива

LSI MegaRAID 9265-8i

LSI позиционирует MegaRAID 9265-8i, как устройство для рынка малого и среднего бизнеса. Эта карта подходит для обеспечения надёжности в облаках и других бизнес-приложений. MegaRAID 9265-8i – один из наиболее дорогих контроллеров в нашем тесте (он стоит $630), но как показывает тест, эти деньги платятся за его реальные преимущества. Перед тем, как мы представим результаты тестов, давайте обсудим технические особенности этих контроллеров и программные приложения FastPath и CacheCade.

LSI MegaRAID 9265-8i использует двухъядерный LSI SAS2208 ROC, использующий интерфейс PCIe 2.0 с восемью линиями. Число 8 в конце наименования устройства означает наличие восьми внутренних портов SATA/SAS, каждый из которых поддерживает скорость 6 Гбит/с. До 128 устройства хранения могут быть подключены к контроллеру через экспандеры SAS. Карта LSI cодержит 1 Гбайт кэша DDR3-1333 и поддерживает уровни RAID 0, 1, 5, 6, 10 и 60.

Настройка ПО и RAID, FastPath и CacheCade

LSI утверждает, что FastPath может существенно ускорить работу систем ввода/вывода при подключении SSD. По словам экспертов компании LSI, FastPath работает с любым SSD, заметно увеличивая производительность записи/чтения RAID-массива на базе SSD: в 2.5 раза при записи и в 2 раза при чтении, достигая 465 000 IOPS. Эту цифру мы не смогли проверить. Тем не менее, эта карта смогла выжать максимум из пяти SSD и без использования FastPath.

Следующее приложение для MegaRAID 9265-8i называется CacheCade. С его помощью можно использовать один SSD в качестве кэш-памяти для массива жёстких дисков. По словам экспертов LSI, это может ускорить процесс считывания раз в 50, в зависимости от размера рассматриваемых данных, приложений и метода использования. Мы попробовали работу этого приложения на массиве RAID 5, состоящем из 7 жёстких дисков и одного SSD (SSD использовался для кэша). По сравнению с системой RAID 5 из 8 жёстких дисков, стало очевидно, что CacheCade не только повышает скорость ввода/вывода, но также и общую производительность (тем больше, чем меньше объём постоянно используемых данных). Для тестирования мы использовали 25 Гбайт данных и получили 3877 IOPS на Iometer в шаблоне для Web-сервера, тогда как обычный массив жёстких дисков позволял получить только 894 IOPS.

Производительность

В конце концов оказывается, что LSI MegaRAID 9265-8i – это самый быстрый из всех SAS RAID-контроллеров в этом обзоре в операциях ввода/вывода. Однако, в процессе последовательных операций чтения/записи контроллер демонстрирует производительность среднего уровня, поскольку его производительность при последовательных действиях сильно зависит от уровня RAID, который вы используете. При тестировании жёсткого диска на уровне RAID 0 мы получаем скорость последовательно чтения 1080 Мбайт/с (что существенно превышает показатели конкурентов). Скорость последовательной записи на уровне RAID 0 идёт на уровне 927 Mбайт/с, что также выше, чем у конкурентов. А вот для RAID 5 и 6 контроллеры LSI уступают всем своим конкурентам, превосходя их только в RAID 10. В тесте SSD RAID LSI MegaRAID 9265-8i демонстрирует лучшую производительность при последовательной записи (752 Mбайт/с) и только Areca ARC-1880i превосходит его по параметрам последовательного чтения.

Если вы ищете RAID-контроллер, ориентированный на SSD с высокой производительностью ввода/вывода, то здесь лидер – контроллер LSI. За редким исключением, он занимает первое место в наших тестах ввода/вывода для файл-сервера, Web-сервера и нагрузок для рабочих станций. Когда ваш RAID-массив состоит из SSD, конкуренты LSI ничего не могут ему противопоставить. Например, в бенчмарке для рабочих станций MegaRAID 9265-8i достигает 70 172 IOPS, тогда как оказавшийся на втором месте Areca ARC-1880i, уступает ему практически в два раза - 36 975 IOPS.

ПО для RAID и установка массива

Как и в случае Adaptec, LSI имеет удобные инструменты для управления RAID-массивом через контроллер. Вот несколько скриншотов:

ПО для CacheCade

ПО для RAID

Установка массива

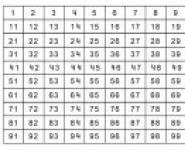

Сравнительная таблица и конфигурация тестового стенда

| Производитель | Adaptec | Areca |

| Продукт | RAID 6805 | ARC-1880i |

| Форм-фактор | Низкопрофильный MD2 | Низкопрофильный MD2 |

| Число портов SAS | 8 | 8 |

| 6 Гбит/с (SAS 2.0) | 6 Гбит/с (SAS 2.0) | |

| Внутренние порты SAS | 2хSFF-8087 | 2хSFF-8087 |

| Внешние порты SAS | Нет | Нет |

| Кэш-память | 512 Мбайт DDR2-667 | 512 Мбайт DDR2-800 |

| Основной интерфейс | PCIe 2.0 (х8) | PCIe 2.0 (х8) |

| XOR и тактовая частота | PMC-Sierra PM8013/Нет данных | Нет данных/800 МГц |

| Поддерживаемые уровни RAID | 0, 1, 1E, 5, 5EE, 6, 10, 50, 60 | 0, 1, 1E, 3, 5, 6, 10, 30, 50, 60 |

| Windows 7, Windows Server 2008/2008 R2, Windows Server 2003/2003 R2, Windows Vista, VMware ESX Classic 4.x (vSphere),Red Hat Enterprise Linux (RHEL), SUSE Linux Enterprise Server (SLES), Sun Solaris 10 x86, FreeBSD, Debian Linux, Ubuntu Linux | Windows 7/2008/Vista/XP/2003, Linux, FreeBSD, Solaris 10/11 x86/x86_64, Mac OS X 10.4.x/10.5.x/10.6.x, VMware 4.x | |

| Аккумулятор | Нет | Опционально |

| Вентилятор | Нет | Есть |

| Производитель | HighPoint | LSI |

| Продукт | RocketRAID 2720SGL | MegaRAID 9265-8i |

| Форм-фактор | Низкопрофильный MD2 | Низкопрофильный MD2 |

| Число портов SAS | 8 | 8 |

| Полоса пропускания SAS на один порт | 6 Гбит/с (SAS 2.0) | 6 Гбит/с (SAS 2.0) |

| Внутренние порты SAS | 2хSFF-8087 | 2хSFF-8087 |

| Внешние порты SAS | Нет | Нет |

| Кэш-память | Нет данных | 1 Гбайт DDR3-1333 |

| Основной интерфейс | PCIe 2.0 (х8) | PCIe 2.0 (х8) |

| XOR и тактовая частота | Marvel 9485/Нет данных | LSI SAS2208/800 МГц |

| Поддерживаемые уровни RAID | 0, 1, 5, 6, 10, 50 | 0, 1, 5, 6, 10, 60 |

| Поддерживаемые операционные системы | Windows 2000, XP, 2003, 2008, Vista, 7, RHEL/CentOS, SLES, OpenSuSE, Fedora Core, Debian, Ubuntu, FreeBSD bis 7.2 | Microsoft Windows Vista/2008/Server 2003/2000/XP, Linux, Solaris (x86), Netware, FreeBSD, Vmware |

| Аккумулятор | Нет | Опционально |

| Вентилятор | Нет | Нет |

Тестовая конфигурация

Мы соединили восемь жёстких дисков Fujitsu MBA3147RC SAS (каждый по 147 Гбайт) с RAID-контроллерами и провели бенчмарки для RAID-уровней 0, 5, 6 и 10. Тесты SSD проводились с пятью дисками Samsung SS1605.

| Аппаратное обеспечение | |

| Процессор | Intel Core i7-920 (Bloomfield) 45 нм, 2.66 ГГц, 8 Мбайт общая L3 кэш-память |

| Материнская плата (LGA 1366) | Supermicro X8SAX, Revision: 1.0, Чипсет Intel X58 + ICH10R, BIOS: 1.0B |

| Контроллер | LSI MegaRAID 9280-24i4e Прошивка: v12.12.0-0037 Driver: v4.32.0.64 |

| Оперативная память | 3 x 1 Гбайт DDR3-1333 Corsair CM3X1024-1333C9DHX |

| Жёсткий диск | Seagate NL35 400 Гбайт, ST3400832NS, 7200 об/мин, SATA 1.5 Гбит/с, 8 Мбайт кэш-память |

| Блок питания | OCZ EliteXstream 800 W, OCZ800EXS-EU |

| Бенчмарки | |

| Производительность | CrystalDiskMark 3 |

| Производительность ввода/вывода | Iometer 2006.07.27 File server Benchmark Web server Benchmark Database Benchmark Workstation Benchmark Streaming Reads Streaming Writes 4k Random Reads 4k Random Writes |

| ПО и драйверы | |

| Операционная система | Windows 7 Ultimate |

Результаты тестов

Проиводительность ввода/вывода в RAID 0 и 5

Бенчмарки в RAID 0 не показывают существенной разницы между RAID-контроллерами, за исключением HighPoint RocketRAID 2720SGL.

Бенчмарк в RAID 5 не помогает контроллеру HighPoint обрести утраченные позиции. В отличие от бенчмарка в RAID 0, все три более быстрых контроллера более отчётливо проявляют здесь свои слабые и сильные стороны.

Производительность ввода/вывода в RAID 6 и 10

LSI оптимизировала свой контроллер MegaRAID 9265 для работы с базами данных, файл-серверами и нагрузками для рабочих станций. Бенчмарк для Web-севера хорошо проходят все контроллеры, демонстрируя одинаковую производительность.

В варианте RAID 10 за первое место борются Adaptec и LSI, а HighPoint RocketRAID 2720SGL занимает последнее место.

Производительность при вводе/выводе на SSD

Здесь лидирует LSI MegaRAID 9265, которая использует все преимущества твердотельных систем хранения.

Пропускная способность в RAID 0, 5 и в деградированном режиме RAID 5

LSI MegaRAID 9265 c лёгкостью лидирует в этом бенчмарке. Adaptec RAID 6805 сильно отстаёт.

HighPoint RocketRAID 2720SGL без кэша хорошо справляется с последовательными операциями в RAID 5. Не сильно уступают ему и другие контроллеры.

Деградированный RAID 5

Пропускная способность в RAID 6, 10 и в деградированном режиме RAID 6

Как и в случае RAID 5, HighPoint RocketRAID 2720SGL демонстрирует самую высокую пропускную способность для RAID 6, оставляя второе место для Areca ARC-1880i. Впечатление такое, что LSI MegaRAID 9265-8i просто не любит RAID 6.

Деградированный RAID 6

Здесь уже LSI MeagaRAID 9265-8i показывает себя в лучшем свете, хотя и пропускает вперед Areca ARC-1880i.

LSI CacheCade

Какой же 6 Гбит/с SAS-контроллер лучший?

В общем, все четыре SAS RAID-контроллера, которые мы тестировали, продемонстрировали хорошую производительность. У всех есть вся необходимая функциональность, и все они с успехом могут используются в серверах начального и среднего уровня. Кроме выдающейся производительности, они обладают и такими важными функциями, как работа в смешанном окружении с поддержкой SAS и SATA и масштабирование через SAS-экспандеры. Все четыре контроллера поддерживают стандарт SAS 2.0, он поднимает пропускную способность с 3 Гбит/с до 6 Гбит/с на порт, а кроме этого вводит такие новые функции, как зонирование SAS, что позволяет многим контроллерам получить доступ к ресурсам хранения данных через один SAS-экспандер.

Несмотря на такие схожие черты, как низкопрофильный форм-фактор, интерфейс PCI Express на восемь линий и восемь SAS 2.0 портов, у каждого контроллера есть свои собственные сильные и слабые стороны, анализируя которые и можно выдать рекомендации по их оптимальному использованию.

Итак, самый быстрый контроллер – это LSI MegaRAID 9265-8i, особенно в отношении пропускной способности ввода/вывода. Хотя и у него есть слабые места, в частности, не слишком высокая производительность в случаях RAID 5 и 6. MegaRAID 9265-8i лидирует в большинстве бенчмарков и является прекрасным решением профессионального уровня. Стоимость этого контроллера – $630 – самая высокая, об этом тоже нельзя забывать. Но за эту высокую стоимость вы получаете прекрасный контроллер, который опережает своих конкурентов, особенно при работе с SSD. Он обладает и прекрасной производительностью, которая становится особенно ценной при подключении систем хранения большого объёма. Более того, вы можете увеличить производительность LSI MegaRAID 9265-8i, используя FastPath или CacheCade, за которые естественно надо будет заплатить дополнительно.

Контроллеры Adaptec RAID 6805 и Areca ARC-1880i демонстрируют одинаковую производительность и очень похожи по своей стоимости ($460 и $540). Оба хорошо работают, как показывают различные бенчмарки. Контроллер Adaptec показывает чуть более высокую производительность, чем контроллер Areca, он также предлагает востребованную функцию ZMCP (Zero Maintenance Cache Protection), которая заменяет обычное резервирование при отказе питания и позволяет продолжать работу.

HighPoint RocketRAID 2720SGL продаётся всего за $170, что гораздо дешевле трёх остальных протестированных контроллеров. Производительность этого контроллера вполне достаточна, если вы работаете с обычными дисками, хотя и хуже, чем у контроллеров Adaptec или Areca. И не стоит использовать этот контроллер для работы с SSD.

Сегодняшний файл-сервер или web-сервер никак не обходится без RAID-массива. Только этот режим работы может обеспечить нужную пропускную способность и скорость работы с системой хранения данных. До недавнего времени единственными жесткими дисками, подходящими для такой работы были диски с интерфейсом SCSI и скоростью вращения шпинделя 10-15 тысяч оборотов в минуту. Для работы таких дисков требовался отдельный контроллер SCSI. Скорость передачи данных по SCSI достигала 320 Мб/с, однако интерфейс SCSI - это обычный параллельный интерфейс, со всеми его недостатками.

Совсем недавно появился новый дисковый интерфейс. Его назвали SAS (Serial Attached SCSI). Базы отдыха в челябинске -На сегодняшний день уже множество компаний имеют в продуктовой линейке контроллеры для этого интерфейса с поддержкой всех уровней массивов RAID. В нашем мини-обзоре мы рассмотрим двух представителей нового семейства контроллеров SAS от Adaptec. Это 8 портовая модель ASR-4800SAS и 4+4 портовая ASR-48300 12C.

Знакомство с SAS

Что же это за интерфейс такой - SAS? На самом деле SAS - это гибрид SATA и SCSI. Технология вобрала в себя достоинства двух интерфейсов. Начнем с того, что SATA - последовательный интерфейс с двумя независимыми каналами чтения и записи, а каждое устройство SATA подключается к отдельному каналу. SCSI имеет очень эффективный и надежный корпоративный протокол передачи данных, но недостатком является параллельный интерфейс и общая шина для нескольких устройств. Таким образом, SAS свободен от недостатков SCSI, обладает достоинствами SATA и обеспечивает скорость до 300 Мб/с на один канал. По схеме ниже можно примерно представить схему подключения SCSI и SAS.

Двунаправленность интерфейса сводит задержки к нулю, поскольку отсутствует переключение канала на чтение/запись.

Любопытной и положительной особенностью Serial Attached SCSI является то, что этот интерфейс поддерживает диски SAS и SATA, причем одновременно к одному контроллеру можно подключать диски обоих типов. Однако диски с интерфейсом SAS невозможно подключить к контроллеру SATA, так как эти диски, во-первых, требуют специальных команд SCSI (протокол Serial SCSI Protocol) при работе, а во-вторых, физически несовместимы с SATA-колодкой. Каждый диск SAS подключается к собственному порту, но, тем не менее, существует возможность подключить больше дисков, чем имеется портов у контроллера. Такую возможность обеспечивают SAS-расширители (Expander).

Оригинальным отличием колодки диска SAS от колодки диска SATA является дополнительный порт данных, то есть каждый диск Serial Attached SCSI имеет два порта SAS со своим оригинальным ID, таким образом технология обеспечивает избыточность, что повышает надежность.

Кабели SAS немного отличаются от SATA, предусмотрена специальная кабельная оснастка, включенная в комплект SAS-контроллера. Также как и SCSI, жесткие диски нового стандарта могут подключаться не только внутри корпуса сервера, но и снаружи, для чего предусмотрены специальные кабели и оснастка. Для подключения дисков с «горячей заменой» используются специальные платы - backplane, имеющие все необходимые разъемы и порты для подключения дисков и контроллеров.

Как правило, плата backplane расположена в специальном корпусе с салазочным креплением дисков, такой корпус содержит в себе RAID-массив и обеспечивает его охлаждение. В случае выхода из строя одного или нескольких дисков имеется возможность оперативной замены неисправного HDD, причем замена неисправного накопителя не останавливает работу массива - достаточно сменить диск и массив снова полноценно работает.

Адаптеры SAS от Adaptec

Компания Adaptec представила на ваш суд две довольно интересных модели RAID-контроллеров. Первая модель является представительницей бюджетного класса устройств для построения RAID в недорогих серверах начального уровня - это восьмипортовая модель ASR-48300 12C. Вторая модель гораздо более продвинута и предназначена для более серьезных задач, имеет на борту восемь каналов SAS - это ASR-4800SAS. Но давайте рассмотрим подробнее каждую из них. Начнем с более простой и дешевой модели.

Adaptec ASR-48300 12C

Контроллер ASR-48300 12C предназначен для построения небольших RAID-массивов уровней 0, 1 и 10. Таким образом, основные типы дисковых массивов можно построить, используя этот контроллер. Поставляется данная модель в обычной картонной коробке, которая оформлена в сине-черных тонах, на лицевой стороне упаковки имеется стилизованное изображение контроллера, летящего из компьютера, что должно навевать мысли о высокой скорости работы компьютера с данным устройством внутри.

Комплект поставки минимален, но включает все необходимое для начала работы с контроллером. В комплекте содержится следующее.

Контроллер ASR-48300 12C

. Низкопрофильная скоба

. Диск с ПО Storage Manager

. Краткий мануал

. Соединительный кабель с колодками SFF8484 to 4xSFF8482 и питания 0.5 м.

Контроллер предназначен для шины PCI-X 133 МГц, которая имеет очень широкое распространение в серверных платформах. Адаптер предоставляет восемь портов SAS, однако, только четыре порта реализовано в виде разъема SFF8484, к которому подключаются диски внутри корпуса, а оставшиеся четыре канала выведены наружу в виде разъема SFF8470, поэтому часть дисков необходимо подключать снаружи - это может быть внешний бокс с четырьмя дисками внутри.

При использовании экспандера, контроллер имеет возможность работать со 128-ю дисками в массиве. Кроме того, контроллер способен работать в 64-битном окружении и поддерживает соответствующие команды. Карта может быть установлена в низкопрофильный сервер высотой 2U, если поставить идущую в комплекте низкопрофильную заглушку. Общие характеристики платы следующие.

Преимущества

Экономичный контроллер Serial Attached SCSI с технологией Adaptec HostRAID™ для высокопроизводительного хранения важных данных.

Потребности клиента

Идеально для поддержки приложений серверов начального и среднего уровня и рабочих групп, которым требуется высокопроизводительное хранение данных и надежная защита, например, приложений резервного копирования, веб-контента, электронной почты, баз данных и совместного доступа к данным.

Системное окружение — Серверы отделов и рабочих групп

Тип интерфейса системной шины — PCI-X 64 bit/133 МГц, PCI 33/66

Внешние соединения — Один x 4 Infiniband/Serial Attached SCSI (SFF8470)

Внутренние соединения — Один 32 pin x 4 Serial Attached SCSI (SFF8484)

Системные требования — Серверы типа IA-32, AMD-32, EM64T и AMD-64

Разъем 32/64-bit PCI 2.2 или 32/64-bit PCI-X 133

Гарантия — 3 года

Уровни RAID levels — Adaptec HostRAID 0, 1, и 10

Ключевые характеристки RAID

- Поддержка загрузочных массивов

- Автоматическое восстановление

- Управление с помощью ПО Adaptec Storage Manager

- Фоновая инициализация

Размеры платы — 6.35см x 17.78см (включая внешний разъем)

Рабочая температура — от 0° до 50° C

Рассеиваемая мощность — 4 Вт

Mean Time Before Failure (MTBF - наработка на отказ) — 1692573 ч при 40 ºC.

Adaptec ASR-4800SAS

Адаптер под номером 4800 более продвинут функционально. Эта модель позиционируется для более скоростных серверов и рабочих станций. Здесь реализована поддержка практически любых массивов RAID - массивы которые имеются у младшей модели, а также можно сконфигурировать массивы RAID 5, 50, JBOD и Adaptec Advanced Data Protection Suite с RAID 1E, 5EE, 6, 60, Copyback Hot Spare с опцией Snapshot Backup для серверов в башенном корпусе и серверов высокой плотности для монтажа в стойку.

Модель поставляется в аналогичной младшей модели упаковке с оформлением в том же «авиационном» стиле.

В комплекте представлено почти то же самое, что и у младшей карты.

Контроллер ASR-4800SAS

. Полноразмерная скоба

. Диск с драйвером и полным руководством

. Диск с ПО Storage Manager

. Краткий мануал

. Два кабеля с колодками SFF8484 to 4xSFF8482 и питания по 1 м.

Контроллер имеет поддержку шины PCI-X 133 МГц, но имеется и модель 4805, аналогичная функционально, но использующая шину PCI-E x8. Адаптер предоставляет те же восемь портов SAS, однако реализованы все восемь портов в качестве внутренних, соответственно, плата имеет два разъема SFF8484 (под два комплектных кабеля), однако имеется и внешний разъем типа SFF8470 на четыре канала, при подключении к которому один из внутренних разъемов отключается.

Точно так же, как и в младшем устройстве, количество дисков расширяемо до 128 с помощью экспандеров. Но основным отличием модели ASR-4800SAS от ASR-48300 12C является наличие на первой 128 Мб DDR2 ECC памяти, используемой в качестве КЭШа, что ускоряет работу с дисковым массивом и оптимизирует работу с мелкими файлами. Доступен опциональный батарейный модуль для сохранения данных в КЭШе при отключении питания. Общие характеристики платы следующие.

Преимущества — Подключение высокопроизводительных устройств хранения и защиты данных для серверов и рабочих станций

Потребности клиента — Идеально для поддержки приложений серверов и рабочих групп, которым требуется постоянный высокий уровень скорости операций чтения-записи, например, приложений потокового видео, веб-контента, видео по запросу, фиксированного контента и хранения справочных данных.

- Системное окружение — Серверы отделов и рабочих групп и рабочие станции

- Тип интерфейса системной шины — Хост-интерфейс PCI-X 64-bit/133 MHz

- Внешние соединения — Разъем SAS один x4

- Внутренние соединения — Разъемы SAS два x4

- Скорость передачи данных — До 3 ГБ/с на порт

- Системные требования -Архитектура Intel или AMD со свободным разъемом 64-bit 3.3v PCI-X

- Поддерживает архитектуры EM64T и AMD64

- Гарантия — 3 года

- Стандартные уровни RAID — RAID 0, 1, 10, 5, 50

- Стандатные возможности RAID — Горячий резерв, миграция уровней RAID, Online Capacity Expansion, Optimized Disk, Utilization, S.M.A.R.T и поддержка SNMP, а также возможности из Adaptec Advanced

- Data Protection Suite включающие:

- Hot Space (RAID 5EE)

- Striped Mirror (RAID 1E)

- Dual Drive Failure Protection (RAID 6)

- Copyback Hot Spare

- Дополнительные возможности RAID — Snapshot Backup

- Размеры платы — 24см x 11.5см

- Рабочая температура — от 0 до 55 градусов C

- Mean Time Before Failure (MTBF - наработка на отказ) — 931924 ч при 40 ºC.

Тестирование

Тестирование адаптеров - дело непростое. Тем более что большого опыта работы с SAS нами еще не приобретено. Поэтому решено было провести тестирование скорости работы жестких дисков с интерфейсом SAS в сравнении с дисками SATA. Для этого мы использовали имевшиеся у нас диски SAS 73 Гб Hitachi HUS151473VLS300 на 15000rpm с 16Mb буфером и WD 150Гб SATA150 Raptor WD1500ADFD на 10000rpm с 16Mb буфером. Мы провели прямое сравнение двух быстрых дисков, но имеющих разные интерфейсы на двух контроллерах. Тестировались диски в программе HDTach, в которой были получены следующие результаты.

Adaptec ASR-48300 12C

Adaptec ASR-4800SAS

Логично было предположить, что жесткий диск с интерфейсом SAS окажется быстрее, чем SATA, хотя для оценки производительности мы взяли самый быстрый диск WD Raptor, который вполне может поспорить по производительности со многими 15000 об/мин SCSI дисками. Что касается различия между контроллерами - то они минимальны. Конечно, старшая модель предоставляет больше функций, но необходимость в них возникает только в корпоративном секторе применения таких устройств. К таким корпоративным функциям относятся особые уровни RAID и дополнительная КЭШ-память на борту контроллера. Обычный домашний пользователь вряд ли будет устанавливать в домашнем, пусть и по самую крышу модифицированном ПК 8 жестких дисков, собранных в RAID-массив с избыточностью - скорее будет отдано предпочтение задействовать четыре диска под массив уровня 0+1, а оставшиеся будут использоваться для данных. Вот тут-то как раз и пригодится модель ASR-48300 12C. К тому же, некоторые оверклокерские материнские платы имеют интерфейс PCI-X. Достоинством модели для домашнего применения как раз является относительно доступная цена (в сравнении с восемью жесткими дисками) в $350 и простота применения (вставил и подключил). Кроме того, особый интерес представляют жесткие диски 10-тысячники формата 2.5 дюйма. Эти винчестеры имеют меньшее энергопотребление, меньше греются и меньше занимают места.

Выводы

Это необычный обзор для нашего сайта и он больше направлен на изучение интереса со стороны пользователей к обзорам специального аппаратного обеспечения. Сегодня были рассмотрены не только два непривычных RAID-контроллера от известного и успевшего себя зарекомендовать производителя серверного оборудования - компании Adaptec. Это еще и попытка написания первой аналитической статьи на нашем сайте.

Касаемо наших сегодняшних героев, SAS контроллеров Adaptec можно сказать, что очередные два продукта компании удались. Младшая модель, ASR-48300 стоимостью $350, вполне может прижиться в производительном домашнем компьютере и уж тем более в сервере (или компьютере, выполняющем его роль) начального уровня. Для этого модель имеет все предпосылки: удобное ПО Adaptec Storage Manager, поддержку от 8 до 128 дисков, работу с основными уровнями RAID.

Старшая модель предназначена для серьезных задач и, конечно, может использоваться в недорогих серверах, но только в том случае, если имеются особые требования к скорости работы с мелкими файлами и надежности хранения информации, ведь карта поддерживает все уровни RAID-массивов корпоративного класса с избыточностью и имеет 128 Мб быстрой КЭШ-памяти стандарта DDR2 с Error Correction Control (ECC). При этом стоимость контроллера составляет $950.

ASR-48300 12C

Плюсы модели

- Доступность

- Поддержка от 8 до 128 дисков

- Простота использования

- Стабильная работа

- Репутация Adaptec

- Слот PCI-X - для большей популярности не хватает только поддержки более распространенного PCI-E

ASR-4800SAS

- Стабильная работа

- Репутация производителя

- Хорошая функциональность

- Доступность апгрейда (программного и аппаратного)

- Доступность версии с PCI-E

- Простота использования

- Поддержка от 8 до 128 дисков

- 8 внутренних каналов SAS

- Не очень подходит для бюджетного и домашнего секторов применения.

Тесты массивов RAID 6, 5, 1 и 0 с дисками SAS-2 компании Hitachi

Видимо, прошли те времена, когда приличный профессиональный 8-портовый RAID-контроллер стоил весьма внушительных денег. Нынче появились решения для интерфейса Serial Attached SCSI (SAS), которые очень даже привлекательны и по цене, и по функциональности, да и в плане производительности. Об одном из них - этот обзор.

Контроллер LSI MegaRAID SAS 9260-8i

Ранее мы уже писали об интерфейсе SAS второго поколения со скоростью передачи 6 Гбит/с и весьма дешевом 8-портовом HBA-контроллере LSI SAS 9211-8i, предназначенном для организации систем хранения данных начального ценового уровня на базе простейших RAID-массивов SAS и SATA-накопителей. Модель же LSI MegaRAID SAS 9260-8i будет классом повыше - она оснащена более мощным процессором с аппаратным обсчетом массивов уровней 5, 6, 50 и 60 (технология ROC - RAID On Chip), а также ощутимым объемом (512 Мбайт) набортной SDRAM-памяти для эффективного кеширования данных. Этим контроллером также поддерживаются интерфейсы SAS и SATA со скоростью передачи данных 6 Гбит/с, а сам адаптер предназначен для шины PCI Express x8 версии 2.0 (5 Гбит/с на линию), чего теоретически почти достаточно для удовлетворения потребностей 8 высокоскоростных портов SAS. И все это - по розничной цене в районе 500 долларов, то есть лишь на пару сотен дороже бюджетного LSI SAS 9211-8i. Сам производитель, кстати, относит данное решение к серии MegaRAID Value Line, то есть экономичным решениям.

8-портовый SAS-контроллер LSIMegaRAID SAS9260-8i и его процессор SAS2108 с памятью DDR2

Плата LSI SAS 9260-8i имеет низкий профиль (форм-фактор MD2), оснащена двумя внутренними разъемами Mini-SAS 4X (каждый из них позволяет подключать до 4 SAS-дисков напрямую или больше - через порт-мультипликаторы), рассчитана на шину PCI Express x8 2.0 и поддерживает RAID-массивы уровней 0, 1, 5, 6, 10, 50 и 60, динамическую функциональность SAS и мн. др. Контроллер LSI SAS 9260-8i можно устанавливать как в рэковые серверы формата 1U и 2U (серверы классов Mid и High-End), так и в корпуса ATX и Slim-ATX (для рабочих станций). Поддержка RAID производится аппаратно - встроенным процессором LSI SAS2108 (ядро PowerPC на частоте 800 МГц), доукомплектованным 512 Мбайт памяти DDR2 800 МГц с поддержкой ECC. LSI обещает скорость работы процессора с данными до 2,8 Гбайт/с при чтении и до 1,8 Гбайт/с при записи. Среди богатой функциональности адаптера стоит отметить функции Online Capacity Expansion (OCE), Online RAID Level Migration (RLM) (расширение объема и изменение типа массивов «на ходу»), SafeStore Encryption Services и Instant secure erase (шифрование данных на дисках и безопасное удаление данных), поддержку твердотельных накопителей (технология SSD Guard) и мн. др. Опционально доступен батарейный модуль для этого контроллера (с ним максимальная рабочая температура не должна превышать +44,5 градусов Цельсия).

Контроллер LSI SAS 9260-8i: основные технические характеристики

| Системный интерфейс | PCI Express x8 2.0 (5 ГТ/с), Bus Master DMA |

| Дисковый интерфейс | SAS-2 6 Гбит/с (поддержка протоколов SSP, SMP, STP и SATA) |

| Число портов SAS | 8 (2 разъема x4 Mini-SAS SFF8087), поддержка до 128 накопителей через порт-мультипликаторы |

| Поддержка RAID | уровни 0, 1, 5, 6, 10, 50, 60 |

| Процессор | LSI SAS2108 ROC (PowerPC @ 800 МГц) |

| Встроенная кеш-память | 512 Мбайт ECC DDR2 800 МГц |

| Энергопотребление, не более | 24 Вт (питание +3,3 В и +12 В от слота PCIe) |

| Диапазон температур работы/хранения | 0…+60 °С / −45…+105 °С |

| Форм-фактор, габариты | MD2 low-profile, 168×64,4 мм |

| Значение MTBF | >2 млн. ч |

| Гарантия производителя | 3 года |

Типичные применения LSI MegaRAID SAS 9260-8i производитель обозначил так: разнообразные видеостанции (видео по запросу, видеонаблюдение, создание и редактирование видео, медицинские изображения), высокопроизводительные вычисления и архивы цифровых данных, многообразные серверы (файловый, веб, почтовый, базы данных). В общем, подавляющее большинство задач, решаемых в малом и среднем бизнесе.

В бело-оранжевой коробке с легкомысленно улыбающимся зубастым дамским личиком на «титуле» (видимо, чтобы лучше завлечь бородатых сисадминов и суровых систембилдеров) находится плата контроллера, брекеты для ее установки в корпуса ATX, Slim-ATX и пр., два 4-дисковых кабеля с разъемами Mini-SAS на одном конце и обычным SATA (без питания) - на другом (для подключения до 8 дисков к контроллеру), а также CD с PDF-документацией и драйверами для многочисленных версий Windows, Linux (SuSE и RedHat), Solaris и VMware.

Комплект поставки коробочной версии контроллера LSI MegaRAID SAS 9260-8i (мини-платка ключа MegaRAID Advanced Services Hardware Key поставляется по отдельному запросу)

Со специальным аппаратным ключом (он поставляется отдельно) для контроллера LSI MegaRAID SAS 9260-8i доступны программные технологии LSI MegaRAID Advanced Services: MegaRAID Recovery, MegaRAID CacheCade, MegaRAID FastPath, LSI SafeStore Encryption Services (их рассмотрение выходит за рамки данной статьи). В частности, в плане повышения производительности массива традиционных дисков (HDD) при помощи добавленного в систему твердотельного накопителя (SSD) будет полезна технология MegaRAID CacheCade, при помощи которой SSD выступает кешем второго уровня для массива HDD (аналог гибридного решения для HDD), в отдельных случаях обеспечивая повышение производительности дисковой подсистемы до 50 раз. Интерес представляет также решение MegaRAID FastPath, при помощи которого уменьшаются задержка обработки процессором SAS2108 операций ввода-вывода (за счет отключения оптимизации под НЖМД), что позволяет ускорить работу массива из нескольких твердотельных накопителей (SSD), подключенных напрямую к портам SAS 9260-8i.

Операции по конфигурированию, настройке и обслуживанию контроллера и его массивов удобнее производить в фирменном менеджере в среде операционной системы (настройки в меню BIOS Setup самого контроллера недостаточно богаты - доступны только базовые функции). В частности, в менеджере за несколько кликов мышкой можно организовать любой массив и установить политики его работы (кеширование и пр.) - см. скриншоты.

Примеры скриншотов Windows-менеджера по конфигурированию массивов RAID уровней 5 (вверху) и 1 (внизу).

Тестирование

Для знакомства с базовой производительностью LSI MegaRAID SAS 9260-8i (без ключа MegaRAID Advanced Services Hardware Key и сопутствующих технологий) мы использовали пять высокопроизводительных SAS-накопителей со скоростью вращения шпинделя 15 тыс. об/мин и поддержкой интерфейса SAS-2 (6 Гбит/с) - Hitachi Ultrastar 15K600 HUS156030VLS600 емкостью по 300 Гбайт.

Жесткий диск Hitachi Ultrastar 15K600 без верхней крышки

Это позволит нам протестировать все базовые уровни массивов - RAID 6, 5, 10, 0 и 1, причем не только при минимальном для каждого из них числе дисков, но и «на вырост», то есть при добавлении диска во второй из 4-канальных SAS-портов чипа ROC. Отметим, что у героя этой статьи есть упрощенный аналог - 4-портовый контроллер LSI MegaRAID SAS 9260-4i на той же элементной базе. Поэтому наши тесты 4-дисковых массивов с тем же успехом применимы и к нему.

Максимальная скорость последовательного чтения/записи полезных данных для Hitachi HUS156030VLS600 составляет около 200 Мбайт/с (см. график). Среднее время случайного доступа при чтении (по спецификациям) - 5,4 мс. Встроенный буфер - 64 Мбайт.

График скорости последовательного чтения/записи диска Hitachi Ultrastar 15K600 HUS156030VLS600

Тестовая система была основана на процессоре Intel Xeon 3120, материнской плате с чипсетом Intel P45 и 2 Гбайт памяти DDR2-800. SAS-контроллер устанавливался в слот PCI Express x16 v2.0. Испытания проводились под управлением операционных систем Windows XP SP3 Professional и Windows 7 Ultimate SP1 x86 (чистые американские версии), поскольку их серверные аналоги (Windows 2003 и 2008 соответственно) не позволяют работать некоторым из использованных нами бенчмарков и скриптов. В качестве тестов использовались программы AIDA64, ATTO Disk Benchmark 2.46, Intel IOmeter 2006, Intel NAS Performance Toolkit 1.7.1, C’T H2BenchW 4.13/4.16, HD Tach RW 3.0.4.0 и за компанию Futuremark PCMark Vantage и PCMark05. Тесты проводились как на неразмеченных томах (IOmeter, H2BenchW, AIDA64), так и на отформатированных разделах. В последнем случае (для NASPT и PCMark) результаты снимались как для физического начала массива, так и для его середины (тома массивов максимально доступной емкости разбивались на два равновеликих логических раздела). Это позволяет нам более адекватно оценивать производительность решений, поскольку самые быстрые начальные участки томов, на которых проводятся файловые бенчмарки большинством обозревателей, зачастую не отражают ситуации на остальных участках диска, которые в реальной работе также могут использоваться весьма активно.

Все тесты проводились пятикратно и результаты усреднялись. Подробнее нашу обновленную методику оценки профессиональных дисковых решений мы рассмотрим в отдельной статье.

Остается добавить, что при данном тестировании мы использовали версию прошивки контроллера 12.12.0-0036 и драйверы версии 4.32.0.32. Кеширование записи и чтения для всех массивов и дисков было активировано. Возможно, использование более современной прошивки и драйверов уберегло нас от странностей, замеченных в результатах ранних тестов такого же контроллера . В нашем случае подобных казусов не наблюдалось. Впрочем, и весьма сомнительный по достоверности результатов скрипт FC-Test 1.0 (который в определенных случаях тем же коллегам «хочется назвать разбродом, шатанием и непредсказуемостью») мы тоже в нашем пакете не используем, поскольку ранее многократно замечали его несостоятельность на некоторых файловых паттернах (в частности, наборах множества мелких, менее 100 Кбайт, файлов).

На диаграммах ниже приведены результаты для 8 конфигураций массивов:

- RAID 0 из 5 дисков;

- RAID 0 из 4 дисков;

- RAID 5 из 5 дисков;

- RAID 5 из 4 дисков;

- RAID 6 из 5 дисков;

- RAID 6 из 4 дисков;

- RAID 1 из 4 дисков;

- RAID 1 из 2 дисков.

Под массивом RAID 1 из четырех дисков (см. скриншот выше) в компании LSI, очевидно, понимают массив «страйп+зеркало», обычно обозначаемый как RAID 10 (это подтверждают и результаты тестов).

Результаты тестирования

Чтобы не перегружать веб-страницу обзора бесчисленным набором диаграмм, порой малоинформативных и утомляющих (чем нередко грешат некоторые «оголтелые коллеги»:)), мы свели детальные результаты некоторых тестов в таблицу . Желающие проанализировать тонкости полученных нами результатов (например, выяснить поведение фигурантов в наиболее критичных для себя задачах) могут сделать это самостоятельно. Мы же сделаем упор на наиболее важных и ключевых результатах тестов, а также на усредненных показателях.

Сначала взглянем на результаты «чисто физических» тестов.

Среднее время случайного доступа к данным при чтении на единичном диске Hitachi Ultrastar 15K600 HUS156030VLS600 составляет 5,5 мс. Однако при организации их в массивы этот показатель немного меняется: уменьшается (благодаря эффективному кешированию в контроллере LSI SAS9260) для «зеркальных» массивов и увеличивается - для всех остальных. Наибольший рост (примерно на 6%) наблюдается для массивов уровня 6, поскольку при этом контроллеру приходится одновременно обращаться к наибольшему числу дисков (к трем для RAID 6, к двум - для RAID 5 и к одному для RAID 0, поскольку обращение в этом тесте происходит блоками размером всего 512 байт, что существенно меньше размера блоков чередования массивов).

Гораздо интереснее ситуация со случайным доступом к массивам при записи (блоками по 512 байт). Для единичного диска этот параметр равен около 2,9 мс (без кеширования в хост-контроллере), однако в массивах на контроллере LSI SAS9260 мы наблюдаем существенное уменьшение этого показателя - благодаря хорошему кешированию записи в SDRAM-буфере контроллера объемом 512 Мбайт. Интересно, что наиболее кардинальный эффект получается для массивов RAID 0 (время случайного доступа при записи падает почти на порядок по сравнению с одиночным накопителем)! Это несомненно должно благотворно отразиться на быстродействии таких массивов в ряде серверных задач. В то же время, и на массивах с XOR-вычислениями (то есть высокой нагрузкой на процессор SAS2108) случайные обращения на записи не приводят к явному проседанию быстродействия - снова благодаря мощному кешу контроллера. Закнонмерно, что RAID 6 здесь чуть медленнее, чем RAID 5, однако разница между ними, по сути, несущественна. Несколько удивило в этом тесте поведение одиночного «зеркала», показавшего самый медленный случайный доступ при записи (возможно, это «фича» микрокода данного контроллера).

Графики скорости линейного (последовательного) чтения и записи (крупными блоками) для всех массивов не имеют каких-либо особенностей (для чтения и записи они практически идентичны при условии задействования кеширования записи контроллера) и все они масштабируются согласно количеству дисков, параллельно участвующих в «полезном» процессе. То есть для пятидискового RAID 0 дисков скорость «упятеряется» относительно одиночного диска (достигая показателя в 1 Гбайт/с!), для пятидискового RAID 5 она «учетверяется», для RAID 6 - «утрояется» (утраивается, конечно же:)), для RAID 1 из четырех дисков - удваивается (никаких «у2яица»! :)), а для простого зеркала - дублирует графики одиночного диска. Эта закономерность наглядно видна, в частности, по показателям максимальной скорости чтения и записи реальных крупных (256 Мбайт) файлов большими блоками (от 256 Кбайт до 2 Мбайт), что мы проиллюстрируем диаграммой теста ATTO Disk Benchmark 2.46 (результаты этого теста для Windows 7 и XP практически идентичны).

Здесь из общей картины неожиданно выпал лишь случай чтения файлов на массиве RAID 6 из 5 дисков (результаты многократно перепроверены). Впрочем, для чтения блоками 64 Кбайт скорость данного массива набирает положенные ему 600 Мбайт/с. Так что спишем данный факт на «фичу» текущей прошивки. Отметим также, что при записи реальных файлов скорость чуть повыше благодаря кешированию в большом буфере контроллера, причем разница с чтением тем ощутимее, чем меньше реальная линейная скорость массива.

Что же касается скорости интерфейса, измеряемой обычно по показателям записи и чтения буфера (многократные обращения по одному и тому же адресу дискового тома), то здесь мы вынуждены констатировать, что почти для всех массивов она оказалась одинакова благодаря включению кеша контроллера для этих массивов (см. таблицу). Так, показатели при записи для всех участников нашего теста составили примерно 2430 Мбайт/с. Заметим, что шина PCI Express x8 2.0 теоретически дает скорость 40 Гбит/с или 5 Гбайт/с, однако по полезным данным теоретический предел пониже - 4 Гбайт/с, и значит, в нашем случае контроллер действительно работал по версии 2.0 шины PCIe. Таким образом, измеренные нами 2,4 Гбайт/с - это, очевидно, реальная пропускная способность набортной памяти контроллера (память DDR2-800 при 32-битной шине данных, что видно из конфигурации ECC-чипов на плате, теоретически дает до 3,2 Гбайт/с). При чтении же массивов кеширование не столь «всеобъемлюще», как при записи, поэтому и измеряемая в утилитах скорость «интерфейса», как правило, ниже скорости чтения кеш-памяти контроллера (типичные 2,1 Гбайт/с для массивов уровней 5 и 6), и в некоторых случаях она «падает» до скорости чтения буфера самих жестких дисков (около 400 Мбайт/с для одиночного винчестера, см. график выше), помноженной на число «последовательных» дисков в массиве (это как раз случаи RAID 0 и 1 из наших результатов).

Что ж, с «физикой» мы в первом приближении разобрались, пора переходить к «лирике», то есть к тестам «реальных» пацанов приложений. К слову, интересно будет выяснить, масштабируется ли производительность массивов при выполнении комплексных пользовательских задач так же линейно, как она масштабируется при чтении и записи крупных файлов (см. диаграмму теста ATTO чуть выше). Пытливый читатель, надеюсь, уже смог предугадать ответ на этот вопрос.

В качестве «салата» к нашей «лирической» части трапезы подадим десктопные по своей природе дисковые тесты из пакетов PCMark Vantage и PCMark05 (под Windows 7 и XP соответственно), а также похожий на них «трековый» тест приложений из пакета H2BenchW 4.13 авторитетного немецкого журнала C’T. Да, эти тесты исходно создавались для оценки жестких дисков настольных ПК и недорогих рабочих станций. Они эмулируют выполнение на дисках типичных задач продвинутого персонального компьютера - работу с видео, аудио, «фотошопом», антивирусом, играми, своп-файлом, установкой приложений, копированием и записью файлов и др. Поэтому и их результаты в контексте данной статьи не стоит воспринимать как истину в последней инстанции - все-таки на многодисковых массивах чаще выполняются иные задачи. Тем не менее, в свете того, что сам производитель позиционирует данный RAID-контроллер, в том числе, для относительно недорогих решений, подобный класс тестовых задач вполне способен характеризовать некоторую долю приложений, которые в реальности будут выполняться на таких массивах (та же работа с видео, профессиональная обработка графики, свопирование ОС и ресурсоемких приложений, копирование файлов, анитивирус и пр.). Поэтому и значение этих трех комплексных бенчмарков в нашем общем пакете не стоит недооценивать.

В популярном PCMark Vantage в среднем (см. диаграмму) мы наблюдаем очень примечательный факт - производительность данного многодискового решения почти не зависит от типа используемого массива! К слову, в определенных пределах это вывод справедлив и для всех отдельных тестовых треков (типов задач), входящих в состав пакетов PCMark Vantage и PCMark05 (детали см. в таблице). Это может означать либо то, что алгоритмы прошивки контроллера (с кешем и дисками) почти не учитывают специфику работы приложений подобного типа, либо то, что основная часть данных задач выполняется в кеш-памяти самого контроллера (а скорее всего мы наблюдаем комбинацию этих двух факторов). Впрочем, для последнего случая (то есть выполнения треков в большой мере в кеше RAID-коннтроллера) средняя производительность решений оказывается не такой уж высокой - сравните эти данные с результатами тестов некоторых «десктопных» («чипсетаных») 4-дисковых массивов RAID 0 и 5 и недорогих одиночных SSD на шине SATA 3 Гбит/с (см. обзор). Если по сравнению с простым «чипсетным» 4-дисковым RAID 0 (причем на вдвое более медленных винчестерах, чем примененные здесь Hitachi Ultrastar 15K600) массивы на LSI SAS9260 быстрее в тестах PCMark менее чем вдвое, то относительно даже не самого быстрого «бюджетного» одиночного SSD все они однозначно проигрывают! Результаты дискового теста PCMark05 дают аналогичную картину (см. табл .; рисовать отдельную диаграмму для них смысла нет).

Похожую картину (с отдельными оговорками) для массивов на LSI SAS9260 можно наблюдать в еще одном «трековом» бенчмарке приложений - C’T H2BenchW 4.13. Здесь лишь два наиболее медленных (по строению) массива (RAID 6 из 4 дисков и простое «зеркало») заметно отстают от всех остальных массивов, производительность которых, очевидно, достигает того «достаточного» уровня, когда она упирается уже не в дисковую подсистему, а в эффективность работы процессора SAS2108 c кеш-памятью контроллера при данных комплексных последовательностях обращений. А радовать нас в этом контексте может то, что производительность массивов на базе LSI SAS9260 в задачах такого класса почти не зависит от типа используемого массива (RAID 0, 5, 6 или 10), что позволяет использовать более надежные решения без ущерба для итоговой производительности.

Впрочем, «не все коту Масленица» - если мы изменим тесты и проверим работу массивов с реальными файлами на файловой системе NTFS, то картина кардинально изменится. Так, в тесте Intel NASPT 1.7, многие из «предустановленных» сценариев которого имеют достаточно прямое отношение к задачам, типичным для компьютеров, оснащенных контроллером LSI MegaRAID SAS9260-8i, диспозиция массивов похожа на ту, что мы наблюдали в тесте ATTO при чтении и записи крупных файлов - быстродействие пропорционально нарастает по мере роста «линейной» скорости массивов.

На этой диаграмме мы приводим усредненный по всем тестам и паттернам NASPT показатель, тогда как в таблице можно видеть детальные результаты. Подчеркну, что NASPT прогонялся нами как под Windows XP (так обычно поступают многочисленные обозреватели), так и под Windows 7 (что в силу определенных особенностей этого теста делается реже). Дело в том, что Seven (и ее «старший братец» Windows 2008 Server) используют более агрессивные алгоритмы собственного кеширования при работе с файлами, нежели XP. Кроме того, копирование крупных файлов в «Семерке» происходит преимущественно блоками по 1 Мбайт (XP, как правило, оперирует блоками по 64 Кбайт). Это приводит к тому, что результаты «файлового» теста Intel NASPT существенно различаются в Windows XP и Windows 7 - в последней они намного выше, порой более чем вдвое! К слову, мы сравнили результаты NASPT (и других тестов нашего пакета) под Windows 7 с 1 Гбайт и 2 Гбайт установленной системной памяти (есть информация, что при больших объемах системной памяти кеширование дисковых операций в Windows 7 усиливается и результаты NASPT становятся еще выше), однако в пределах погрешности измерений мы не нашли никакой разницы.

Споры о том, под какой ОС (в плане политик кеширования и пр.) «лучше» тестировать диски и RAID-контроллеры, мы оставляем для ветки обсуждений этой статьи. Мы же считаем, что тестировать накопители и решения на их основе надо в условиях, максимально приближенных к реальным ситуациям их эксплуатации. Именно поэтому равную ценность, на наш взгляд, имеют результаты, полученные нами для обеих ОС.

Но вернемся к диаграмме усредненной производительности в NASPT. Как видим, разница между самым быстрым и самым медленным из протестированных нами массивов здесь составляет в среднем чуть менее трех раз. Это, конечно, не пятикратный разрыв, как при чтении и записи крупны файлов, но тоже весьма ощутимо. Массивы расположились фактически пропорционально своей линейной скорости, и это не может не радовать: значит, процессор LSI SAS2108 достаточно шустро обрабатывает данные, почти не создавая узких мест при активной работе массивов уровней 5 и 6.

Справедливости ради нужно отметить, что и в NASPT есть паттерны (2 из 12), в которых наблюдается та же картина, что и в PCMark c H2BenchW, а именно что производительность всех протестированных массивов практически одинакова! Это Office Productivity и Dir Copy to NAS (см. табл.). Особенно явно это под Windows 7, хотя и для Windows XP тенденция «сближения» налицо (по сравнению с другими паттернами). Впрочем, и в PCMark c H2BenchW есть паттерны, где налицо рост производительности массивов пропорционально их линейной скорости. Так что все не так просто и однозначно, как может некоторым хотелось бы.

Поначалу я хотел обсудить диаграмму с общими показателями быстродействия массивов, усредненными по всем тестам приложений (PCMark+H2BenchW+NASPT+ATTO), то есть вот эту:

Однако обсуждать здесь особо нечего: мы видим, что поведение массивов на контроллере LSI SAS9260 в тестах, эмулирующих работу тех или иных приложений, может кардинально различаться в зависимости от применяемых сценариев. Поэтому выводы о пользе той или иной конфигурации лучше делать, исходя из того, какие именно задачи вы собираетесь при этом выполнять. И в этом нам может заметно помочь еще один профессиональный тест - синтетические паттерны для IOmeter, эмулирующие ту или иную нагрузку на систему хранения данных.

Тесты в IOmeter

В данном случае мы опустим обсуждение многочисленных паттернов, тщательно измеряющих скорость работы в зависимости от размера блока обращения, процента операций записи, процента случайных обращений и пр. Это, по сути, чистая синтетика, дающая мало полезной практической информации и представляющая интерес скорее чисто теоретически. Ведь основные практические моменты касательно «физики» мы уже выяснили выше. Нам важнее сосредоточиться на паттернах, эмулирующих реальную работу - серверов различного типа, а также операций с файлами.

Для эмуляции серверов типа File Server, Web Server и DataBase (сервер базы данных) мы воспользовались одноименными и хорошо известными паттернами, предложенными в свое время Intel и StorageReview.com. Для всех случаев мы протестировали массивы при глубине очереди команд (QD) от 1 до 256 с шагом 2.

В паттерне «База данных», использующих случайные обращения к диску блоками по 8 Кбайт в пределах всего объема массива, можно наблюдать существенное преимущество массивов без контроля четности (то есть RAID 0 и 1) при глубине очереди команд от 4 и выше, тогда как все массивы с контролем четности (RAID 5 и 6) демонстрируют очень близкое быстродействие (несмотря на двукратное различие между ними в скорости линейных обращений). Ситуация объясняется просто: все массивы с контролем четности показали в тестах на среднее время случайного доступа близкие значения (см. диаграмму выше), а именно этот параметр в основном определяет производительность в данном тесте. Интересно, что быстродействие всех массивов нарастает практически линейно с ростом глубины очереди команд вплоть до 128, и лишь при QD=256 для некоторых случаев можно видеть намек на насыщение. Максимальная производительность массивов с контролем четности при QD=256 составила около 1100 IOps (операций в секунду), то есть на обработку одной порции данных в 8 Кбайт процессор LSI SAS2108 тратит менее 1 мс (около 10 млн однобайтовых XOR-операций в секунду для RAID 6; разумеется, процессор при этом выполняет параллельно и другие задачи по вводу-выводу данных и работе с кеш-памятью).

В паттерне файлового сервера, использующего блоки разного размера при случайных обращениях чтения и записи к массиву в пределах всего его объема, мы наблюдаем похожую на DataBase картину с той разницей, что здесь пятидисковые массивы с контролем четности (RAID 5 и 6) заметно обходят по скорости свои 4-дисковые аналоги и демонстрируют при этом почти идентичную производительность (около 1200 IOps при QD=256)! Видимо, добавление пятого диска на второй из двух 4-канальных SAS-портов контроллера каким-то образом оптимизирует вычислительные нагрузки на процессор (за счет операций ввода-вывода?). Возможно, стоит сравнить по скорости 4-дисковые массивы, когда накопители попарно подключены к разным Mini-SAS-разъемам контроллера, чтобы выявить оптимальную конфигурацию для организации массивов на LSI SAS9260, но это уже задача для другой статьи.

В паттерне веб-сервера, где, по замыслу его создателей, отсутствуют как класс операции записи на диск (а значит, и вычисление XOR-функций на запись), картина становится еще интереснее. Дело в том, что все три пятидисковых массива из нашего набора (RAID 0, 5 и 6) показывают здесь идентичное быстродействие, несмотря на заметную разницу между ними по скорости линейного чтения и вычислений по контролю четности! К слову, эти же три массива, но из 4 дисков, также идентичны по скорости друг другу! И лишь RAID 1 (и 10) выпадает из общей картины. Почему так происходит, судить сложно. Возможно, контроллер имеет очень эффективные алгоритмы выборки «удачных дисков» (то есть тех из пяти или четырех дисков, с которых первыми приходят нужные данные), что в случае RAID 5 и 6 повышает вероятность более раннего поступления данных с пластин, заранее подготавливая процессор для нужных вычислений (вспомним про глубокую очередь команд и большой буфер DDR2-800). А это в итоге может скомпенсировать задержку, связанную с XOR-вычислениями и уравнивает их в «шансах» с «простым» RAID 0. В любом случае, контроллер LSI SAS9260 можно только похвалить за экстремально высокие результаты (около 1700 IOps для 5-дисковых массивов при QD=256) в паттерне Web Server для массивов с контролем четности. К сожалению, ложкой дегтя стала весьма низкая производительность двухдискового «зеркала» во всех этих серверных паттернах.

Паттерну Web Server вторит наш собственный паттерн, эмулирующий случайное чтение небольших (64 Кбайт) файлов в пределах всего пространства массива.

Снова результаты объединились в группы - все 5-дисковые массивы идентичны друг другу по скорости и лидируют в нашем «забеге», 4-дисковые RAID 0, 5 и 6 тоже не отличить друг от друга по производительности, и лишь «зеркалки» выпадают из общей массы (к слову, 4 дисковая «зеркалка», то есть RAID 10 оказывается быстрее всех остальных 4-дисковых массивов - видимо, за счет того же самого алгоритма «выбора удачного диска»). Подчеркнем, что данные закономерности справедливы лишь для большой глубины очереди команд, тогда как при малой очереди (QD=1-2) ситуация и лидеры могут быть совсем иными.

Все меняется при работе серверов с крупными файлами. В условиях современного «потяжелевшего» контента и новых «оптимизированных» ОС типа Windows 7, 2008 Server т.п. работа с мегабайтными файлами и блоками данных по 1 Мбайт приобретает все более важное значение. В этой ситуации наш новый паттерн, эмулирующий случайное чтение 1-мегабайтных файлов в пределах всего диска (детали новых паттернов будут описаны в отдельной статье по методике), оказывается как нельзя кстати, чтобы более полно оценить серверный потенциал контроллера LSI SAS9260.

Как видим, 4-дисковое «зеркало» здесь уже никому не оставляет надежд на лидерство, явно доминируя при любой очереди команд. Его производительность также сначала растет линейно с ростом глубины очереди команд, однако при QD=16 для RAID 1 она выходит на насыщение (скорость около 200 Мбайт/с). Чуть «позже» (при QD=32) «насыщение» производительности наступает у более медленных в этом тесте массивов, среди которых «серебро» и «бронзу» приходится отдать RAID 0, а массивы с контролем четности оказываются в аутсайдерах, уступив даже прежде не блиставшему RAID 1 из двух дисков, который оказывается неожиданно хорош. Это приводит нас к выводу, что даже при чтении вычислительная XOR-нагрузка на процессор LSI SAS2108 при работе с крупными файлами и блоками (расположенными случайным образом) оказывается для него весьма обременительна, а для RAID 6, где она фактически удваивается, порой даже непомерна - производительность решений едва превышает 100 Мбайт/с, то есть в 6-8 раз ниже, чем при линейном чтении! «Избыточный» RAID 10 здесь применять явно выгоднее.

При случайной записи мелких файлов картина снова разительно отличается от тех, что мы видели ранее.

Дело в том, что здесь уже производительность массивов практически не зависит от глубины очереди команд (очевидно, сказывается огромный кеш контроллера LSI SAS9260 и немаленькие кеши самих винчестеров), зато кардинально меняется с типом массива! В безоговорочных лидерах тут «простенькие» для процессора RAID 0, а «бронза» с более чем двукратным проигрышем лидеру - у RAID 10. Все массивы с контролем четности образовали очень тесную единую группу с двухдисковой зеркалкой (детали по ним приведены на отдельной диаграмме под основной), троекратно проигрывая лидерам. Да, это, безусловно, тяжелая нагрузка на процессор контроллера. Однако такого «провала» я, откровенно говоря, от SAS2108 не ожидал. Порой даже софтовый RAID 5 на «чипсетом» SATA-контроллере (с кешированием средствами Windows и обсчетом при помощи центрального процессора ПК) способен работать шустрее… Впрочем, «свои» 440-500 IOps контроллер при этом все-таки выдает стабильно - сравните это с диаграммой по среднему времени доступа при записи в начале раздела результатов.

Переход на случайную запись крупных файлов по 1 Мбайт приводит к росту абсолютных показателей скорости (для RAID 0 - почти до значений при случайном чтении таких файлов, то есть 180-190 Мбайт/с), однако общая картина почти не меняется - массивы с контролем четности в разы медленнее RAID 0.

Любопытна картина для RAID 10 - его производительность падает с ростом глубины очереди команд, хотя и не сильно. Для остальных массивов такого эффекта нет. Двухдискове «зеркало» здесь снова выглядит скромно.

Теперь посмотрим на паттерны, в которых файлы в равных количествах читаются и пишутся на диск. Такие нагрузки характерны, в частности, для некоторых видеосерверов или при активном копировании/дуплицировании/резервировании файлов в пределах одного массива, а также в случае дефрагментации.

Сначала - файлы по 64 Кбайт случайным образом по всему массиву.

Здесь очевидно некоторое сходство с результатами паттерна DataBase, хотя абслютные скорости у массивов раза в три повыше, да и при QD=256 уже заметно некоторое насыщение производительности. Больший (по сравнению с паттерном DataBase) процент операций записи в этом случае приводит к тому, что массивы с контролем четности и двухдисковое «зеркало» становятся явными аутсайдерами, существенно уступая по скорости массивам RAID 0 и 10.

При переходе на файлы по 1 Мбайт данная закономерность в целом сохраняется, хотя абсолютные скорости примерно утраиваются, а RAID 10 становится таким же быстрым, как 4-дисковый «страйп», что не может не радовать.

Последним паттерном в этой статье будет случай последовательного (в противовес случайным) чтения и записи крупных файлов.

И тут уже многим массивам удается разогнаться до весьма приличных скоростей в районе 300 Мбайт/с. И хотя более чем двукратный разрыв между лидером (RAID 0) и аутсайдером (двухдисковый RAID 1) сохраняется (заметим, что при линейном чтении ИЛИ записи этот разрыв пятикратен!), вошедший в тройку лидеров RAID 5, да и подтянувшиеся остальные XOR-массивы не могут не обнадеживать. Ведь если судить по тому перечню применений данного контроллера, который приводит сама LSI (см. начало статьи), многие целевые задачи будут использовать именно данный характер обращений к массивам. И это определенно стоит учитывать.

В заключение приведу итоговую диаграмму, в которой усреднены показатели всех озвученных выше паттернов теста IOmeter (геометрически по всем паттернам и очередям команд, без весовых коэффициентов). Любопытно, что если усреднение данных результатов внутри каждого паттерна проводить арифметически с весовыми коэффициентами 0,8, 0,6, 0,4 и 0,2 для очередей команд 32, 64, 128 и 256 соответственно (что условно учитывает падение доли операций с высокой глубиной очереди команд в общей работе накопителей), то итоговый (по всем паттернам) нормированный индекс быстродействия массивов в пределах 1% совпадет со средним геометрическим.

Итак, средняя «температура по больнице» в наших паттернах для теста IOmeter показывает, что от «физики с матемачихой» никуда не уйти - однозначно лидируют RAID 0 и 10. Для массивов с контролем четности чуда не произошло - процессор LSI SAS2108 хоть и демонстрирует в некоторых случаях приличную производительность, в целом не может «дотянуть» такие массивы до уровня простого «страйпа». При этом интересно, что 5-дисковые конфигурации явно прибавляют по сравнению с 4 дисковыми. В частности, 5-дисквый RAID 6 однозначно быстрее 4-дискового RAID 5, хотя по «физике» (времени случайного доступа и скорости линейного доступа) они фактически идентичны. Также огорчило двухдисковое «зеркало» (в среднем оно равноценно 4-дисковому RAID 6, хотя для зеркала двух XOR-вычислений на каждый бит данных не требуется). Впрочем, простое «зеркало» - это очевидно не целевой массив для достаточно мощного 8-портового SAS-контроллера с большим кешем и мощным процессором «на борту». :)

Ценовая информация

8-портовый SAS-контроллер LSI MegaRAID SAS 9260-8i с полным комплектом предлагается по цене в районе 500 долларов, что можно считать достаточно привлекательным. Его упрощенный 4-портовый аналог еще дешевле. Более точная текущая средняя розничная цена устройства в Москве, актуальная на момент чтения вами данной статьи:

| LSI SAS 9260-8i | LSI SAS 9260-4i |

|---|---|

| $571() | $386() |

Заключение

Суммируя сказано выше, можно заключить, что единых рекомендаций «для всех» по 8-портовому контроллеру LSI MegaRAID SAS9260-8i мы давать не рискнем. О необходимости его использования и конфигурирования тех или иных массивов с его помощью каждый должен делать выводы самостоятельно - строго исходя из того класса задач, которые предполагается при этом запускать. Дело в том, что в одних случаях (на одних задачах) этот недорогой «мегамонстр» способен показать выдающуюся производительность даже на массивах с двойным контролем четности (RAID 6 и 60), однако в других ситуациях скорость его RAID 5 и 6 явно оставляет желать лучшего. И спасением (почти универсальным) станет лишь массив RAID 10, который почти с тем же успехом можно организовать и на более дешевых контроллерах. Впрочем, нередко именно благодаря процессору и кеш-памяти SAS9260-8i массив RAID 10 ведет себя здесь ничуть не медленнее «страйпа» из того же числа дисков, обеспечивая при этом высокую надежность решения. А вот чего однозначно стоит избегать с SAS9260-8i, так это двухдисковой «зеркалки» и 4-дисковых RAID 6 и 5 - для данного контроллера это очевидно неоптимальные конфигурации.

Благодарим компанию Hitachi Global Storage Technologies

за предоставленные для тестов жесткие диски.

Коротко о современных RAID-контроллерах

В настоящее время RAID-контроллеры как отдельное решение ориентированы исключительно на специализированный серверный сегмент рынка. Действительно, все современные материнские платы для пользовательских ПК (не серверные платы) имеют интегрированные программно-аппаратные SATA RAID-контроллеры, возможностей которых с избытком хватает для пользователей ПК. Правда, нужно иметь в виду, что эти контроллеры ориентированы исключительно на использование операционной системы Windows. В операционных системах семейства Linux RAID-массивы создаются программным методом, и все расчеты переносятся с RAID-контроллера на центральный процессор.

В серверах традиционно применяются либо программно-аппаратные, либо чисто аппаратные RAID-контроллеры. Аппаратный RAID-контроллер позволяет создавать и обслуживать RAID-массив без участия операционной системы и центрального процессора. Такие RAID-массивы видятся операционной системой как один диск (SCSI-диск). При этом никакого специализированного драйвера не нужно - используется стандартный (входящий в состав операционной системы) драйвер SCSI-диска. В этом плане аппаратные контроллеры являются платформенно-независимыми, а настройка RAID-массива производится через BIOS контроллера. Аппаратный RAID-контроллер не задействует центральный процессор при расчете всех контрольных сумм и т.п., поскольку для расчетов применяет свой специализированный процессор и оперативную память.

Программноаппаратные контроллеры требуют обязательного наличия специализированного драйвера, который подменяет собой стандартный драйвер SCSI-диска. Кроме того, программно-аппаратные контроллеры комплектуются утилитами управления. В этом плане программно-аппартные контроллеры привязаны к конкретной операционной системе. Все необходимые расчеты в этом случае также выполняются процессором самого RAID-контроллера, но использование программного драйвера и утилиты управления позволяет управлять контроллером через операционную систему, а не только через BIOS контроллера.